“Naive” KI-basierte Lösungen führen oft zu wackligen, schwer wartbaren und letztendlich erfolglosen Produkten. Der Schlüssel zum Erfolg in der KI liegt in der Anwendung eines bewusst gewählten strategischen “well-architected” Ansatzes, der den vorhandenen vielfältigen Lösungsstack in dieser sich schnell entwickelnden neuen technischen Domäne berücksichtigt.

Dieser Artikel dient als Leitfaden. Er zielt darauf ab, den Unterschied zwischen kurzsichtiger KI-Implementierung (“Lasst uns einfach RAG verwenden”) und durchdacht gestalteten KI-Systemen zu analysieren. Darüber hinaus wird eine Reihe von zentralen Technologien und Ansätzen vorgestellt, die die KI-Lösungslandschaft auffächern und Architekten einen deutlich erweiterten Werkzeugkasten bieten, um robuste, skalierbare und wirkungsvolle KI-gestützte Systeme zu bauen.

‘Naive’ KI: Typische Stolpersteine

In der Anfangsphase Ihrer Arbeit mit KI scheitern viele Organisationen mit schnellen Lösungen und oberflächlichen Integrationen. Dies führt oft zu dem, was wir als “naive KI” klassifizieren. Dazu gehören Merkmale wie:

- Behandlung von Modellen als Black Boxes: Einsatz vortrainierter Modelle ohne Verständnis ihrer Grenzen, Biases oder internen Funktionsweisen. Dies führt zu unvorhersehbarem Verhalten und erschwert Debugging und Fine-Tuning.

- Fehlende Datenstrategie: Konzentration ausschließlich auf das Modelltraining ohne einen umfassenden Plan für Datenerfassung, -speicherung, -qualität, -governance und -herkunft. KI-Modelle sind nur so gut wie die Daten, mit denen sie trainiert werden, und schlechte Datenhygiene lähmt selbst die fortschrittlichsten Algorithmen.

- Mangel an Lifecycle-Management: Bereitstellung von Modellen als statische Einheiten ohne Planung für kontinuierliche Überwachung, Neutraining, Versionierung oder Außerbetriebnahme. KI-Modelle verschlechtern sich im Laufe der Zeit (sogenannte “Model Drift”).

- Schlechte Integration: Aufsetzen von KI-Komponenten auf bestehende Systeme ohne Berücksichtigung eines nahtlosen Datenflusses, API-Designs, Fehlerbehandlung und allgemeiner Systemresilienz. Dies schafft Silos und betriebliche Schwierigkeiten.

- Vernachlässigung nicht-funktionaler Anforderungen: Übersehen wichtiger Aspekte wie Sicherheit, Datenschutz (besonders bei sensiblen Daten), Compliance, Skalierbarkeit und Kostenmanagement.

- Fehlen menschlicher Kontrolle und Erklärbarkeit: Einsatz von KI in kritischen Prozessen ohne Mechanismen für menschliches Eingreifen oder Verständnis, warum ein Modell eine bestimmte Entscheidung getroffen hat. Dies untergräbt das Vertrauen in die Lösung und verhindert die Akzeptanz beim Nutzer.

- Isolierte Optimierungen: Konzentration ausschließlich auf die Verbesserung der Genauigkeit eines Modells auf einem Benchmark-Datensatz, anstatt seine Leistung und Auswirkung im breiteren Geschäftsprozess und Systemkontext zu bewerten.

- Künstlich begrenzter Lösungsraum: Ohne umfassendes Wissen über die verfügbaren KI-Technologien und deren Vor- und Nachteile wählen Implementierer Technologien nach Hörensagen, anstatt tiefere Recherchen durchzuführen. Die erste sichtbare Technologie wird ohne vorherige Sorgfaltspflicht angewendet.

Naive KI-Implementierungen sind anfällig für Fehler, schwer zu warten, langfristig teuer und können sogar neue Risiken einführen. Sie liefern oft begrenzten Geschäftswert und hinterlassen Stakeholder desillusioniert vom Potenzial der KI.

Die Prinzipien für ‘well-architected’ KI

Im Gegensatz dazu basiert ein ‘well-architected’ KI-System auf soliden Ingenieursprinzipien, strategischer Voraussicht und einem tiefen Verständnis der Besonderheiten, die mit dem Aufbau auf KI einhergehen. Architekten sollten KI angehen, indem sie sich an folgende Prinzipien halten:

- Datenzentriertheit: Anerkennung von Daten als erstklassiger Bürger. Dies umfasst die Einrichtung robuster Datenpipelines, die Implementierung starker Daten-Governance, die Sicherstellung der Datenqualität und das strategische Denken über Daten als Produkt.

- Anpassungsfähigkeit und kontinuierliche Verbesserung: Aufbau von Systemen, die sich entwickeln können. Dies umfasst Strategien zur Überwachung der Modellleistung, effiziente Aktualisierung oder Spezialisierung von Modellen und die Einbeziehung von Feedback-Schleifen.

- Zuverlässigkeit, Resilienz und Beobachtbarkeit: Implementierung robuster Fehlerbehandlungs-, Überwachungs-, Protokollierungs- und Alarmierungsmechanismen, um sicherzustellen, dass das KI-System zuverlässig ist und sein Verhalten verstanden werden kann.

- Sicherheit und Governance by Design: Integration von Sicherheitskontrollen, Datenschutzmaßnahmen und Compliance-Anforderungen von Anfang an, nicht als Nachgedanke.

- Mensch-KI-Interaktion: Gestaltung von Schnittstellen und Arbeitsabläufen, die eine effektive Zusammenarbeit zwischen menschlichen Benutzern und KI-Komponenten erleichtern, einschließlich Mechanismen für Aufsicht und Korrektur.

- Ganzheitliche Systemoptimierung: Bewertung und Optimierung der End-to-End-Systemleistung unter Berücksichtigung von Faktoren wie Latenz, Durchsatz, Kosten und Geschäftsauswirkungen, nicht nur isolierte Modellmetriken.

- Ethische KI und verantwortungsvolle Bereitstellung: Aktive Adressierung potenzieller Verzerrungen, Sicherstellung von Fairness und Einrichtung von Leitplanken zur Verhinderung von Missbrauch oder schädlichem Verhalten.

- Modularität und Komponierbarkeit: Gestaltung von KI-Systemen als Sammlung interoperabler Komponenten (Modelle, Datendienste, Agenten, Tools), die unabhängig entwickelt, bereitgestellt und skaliert werden können.

KI-Systeme, die diesen Prinzipien folgen, sind viel besser für ihre Aufgabe geeignet, halten länger und liefern bessere Ergebnisse. Sie liefern greifbaren Geschäftswert und können sich an veränderte Anforderungen und Datenlandschaften anpassen. Um dies zu erreichen, müssen Architekten über simplistische maschinelle Lernkonzepte hinausblicken und neue Paradigmen und Technologien in ihr Toolkit integrieren.

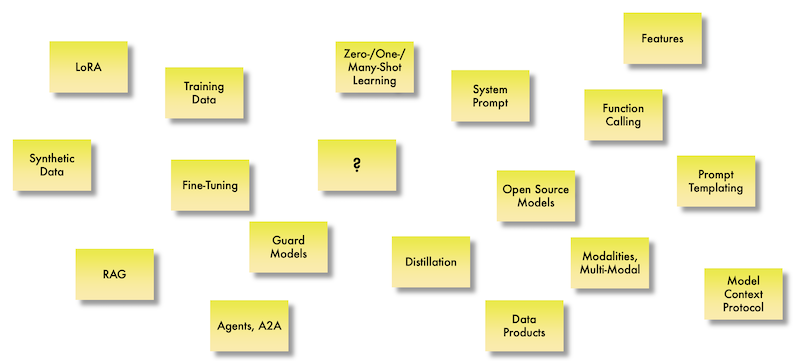

Navigation im modernen KI-Lösungsraum: Schlüsseltechnologien

Weiter geht es mit einer ausgewählten Menge von Technologien und Ansätzen, die aktuell den ‘well-architected’ KI-Tech-Stacks darstellen. Das Verständnis und der strategische Einsatz dieser Elemente erweitert den Lösungsraum für den Aufbau anspruchsvoller KI-Anwendungen erheblich. Lassen Sie uns diese erkunden:

Daten — Das Fundament der KI

- Trainingsdaten: KI benötigt zum Lernen Daten. Architekten müssen die gesamte Pipeline für die Erfassung, Bereinigung, Annotation und Speicherung von Trainingsdaten berücksichtigen. Volumen, Vielfalt und Geschwindigkeit der Daten wirken sich direkt auf die Modellleistung aus. Der ‘well-architected’ Ansatz umfasst Versionierung von Daten, Features, Modellen und Evaluationen.

- Synthetische Daten: Erzeugung künstlicher Daten, die die statistischen Eigenschaften realer Daten nachahmen. Dies ist unschätzbar wertvoll, wenn echte Daten knapp, teuer zu sammeln, sensibel (Datenschutzbedenken) oder verzerrt sind. Architekten können synthetische Daten nutzen, um Trainingssets zu erweitern, die Robustheit des Modells gegenüber Randfällen zu verbessern und das Systemverhalten unter verschiedenen Szenarien zu testen, ohne sensible Produktionsdaten zu verwenden.

- Features: Dies sind die Eingabevariablen, die ein Modell verwendet, um Vorhersagen oder Entscheidungen zu treffen. Feature Engineering – der Prozess der Umwandlung von Rohdaten in Features, die das zugrunde liegende Problem besser für das Modell darstellen – bleibt eine entscheidende Fähigkeit. Architekten müssen Plattformen und Pipelines für automatisiertes Feature Engineering und die Verwaltung von Feature Stores berücksichtigen, um Konsistenz und Wiederverwendbarkeit über verschiedene Modelle und Anwendungen hinweg zu gewährleisten.

- Datenprodukte: Verschiebung der Perspektive von Daten als bloßes Rohmaterial zu Daten als teilbares, wertvolles Produkt mit definiertem Owner, Qualitätsstandards und Auffindbarkeit. Dies steht im Einklang mit Data-Mesh-Prinzipien und ist wesentlich für die Bereitstellung zuverlässiger, kuratierter Datensätze für KI-Entwicklung und -Bereitstellung im gesamten Unternehmen. Architekten können Datenprodukt-Pipelines entwerfen, die den spezifischen Bedürfnissen verschiedener KI-Initiativen dienen und sicherstellen, dass Daten vertrauenswürdig und leicht zugänglich sind.

Modellanpassung und Effizienz: Maßgeschneiderte Intelligenz

- Fine-Tuning: Der Prozess, ein vortrainiertes Modell (oft ein großes Basismodell) zu nehmen und es weiter auf einem kleineren, aufgabenspezifischen Datensatz zu trainieren. Dies passt die Fähigkeiten des Modells an eine bestimmte Domäne oder Aufgabe an, ohne ein Modell von Grund auf neu zu trainieren. Architekten können Fine-Tuning nutzen, um die Leistung großer Modelle zu nutzen und sie gleichzeitig für Unternehmensanwendungsfälle zu spezialisieren, wodurch Genauigkeit und Relevanz verbessert werden.

- LoRA (Low-Rank Adaptation): Eine leichtgewichtige Fine-Tuning-Technik. Anstatt alle Gewichte eines großen vortrainierten Modells zu aktualisieren, fügt LoRA kleine, trainierbare Matrizen in bestimmte Schichten ein. Dies reduziert drastisch die Anzahl der zu trainierenden Parameter, macht Fine-Tuning schneller, weniger rechenintensiv und erfordert deutlich weniger Speicherplatz für angepasste Modelle. Für Architekten bietet LoRA einen praktikablen Weg, große Modelle für zahlreiche nachgelagerte Aufgaben anzupassen, ohne den Overhead des vollständigen Fine-Tunings, was eine breitere Adoption und Experimentierung ermöglicht.

- Destillation: Training eines kleineren “Schüler”-Modells, um das Verhalten eines größeren, komplexeren “Lehrer”-Modells nachzuahmen. Das Schülermodell lernt, die Ausgaben des Lehrers zu reproduzieren, oft mit vergleichbarer Leistung, aber mit deutlich weniger Parametern und Ressourcen. Architekten können Destillation nutzen, um kleinere, schnellere und kostengünstigere Modelle für den Einsatz in Edge-Umgebungen oder für Anwendungen, die eine geringe Latenz erfordern, zu erstellen.

Interaktion und Kontrolle__: Steuerung des KI-Verhaltens

- System Prompt: Im Kontext GenAI ist dies eine zusätzliche besondere Anweisung, die dem Modell bereitgestellt wird, um seine Persona, Einschränkungen oder das Gesamtziel für eine Anfrage des Nutzers zu definieren. Architekten, die KI-Assistenten oder Chat-Anwendungen entwerfen, können System Prompts verwenden, um die KI pro Anfrage auf ein bestimmten Verhalten zu festzulegen. System Prompts können allerdings oft durch den Nutzer ausgehebelt werden.

- BAML (Boundary ML): Eine domänenspezifische Sprache und ein Framework, um Stringenz in das Prompt Engineering zu bringen. BAML behandelt Prompts als typsichere Funktionen mit definierten Eingaben und strukturierten Ausgaben (Schemas). So kann die erwartete Struktur der Antwort eines KI-Modells rigoros definiert werden. Dies vereinfacht die Analyse von KI-Ausgaben und damit die Integration in nachgelagerte Systeme. BAML bietet Tools zum Testen von Prompts, gewährleistet Zuverlässigkeit bei der Extraktion strukturierter Daten, unterstützt verschiedene Modelle und Programmiersprachen und hilft, Prompts systematisch im großen Maßstab zu verwalten. Für Architekten bietet BAML einen Weg, robustere, wartbarere und weniger brüchige KI-Anwendungen zu bauen, indem es der Prompt-Schicht Struktur und Zuverlässigkeit hinzufügt.

- Zero-/One-/Many-Shot Learning: Architekten können diese Techniken, oft durch sorgfältiges Prompt-Design, nutzen, um allgemeine Modelle schnell an neue Aufgaben anzupassen, ohne die Notwendigkeit für umfangreiches Fine-Tuning, was die Entwicklung beschleunigt und die Datenanforderungen für neue Anwendungen reduziert.

- Zero-Shot Learning: Das Modell führt eine Aufgabe aus, für die es keine Beispiele gesehen hat, und verlässt sich ausschließlich auf sein breites Vortrainings-Wissen basierend auf der Prompt-Anweisung.

- One-Shot Learning: Dem Modell wird ein einzelnes Beispiel der Aufgabe im Prompt gegeben, bevor es gebeten wird, sie auszuführen. Oft wird das Format der erwarteten Antwort im Prompt spezifiziert.

- Many-Shot Learning (auch Few-Shot Learning): Dem Modell werden mehrere Beispiele der Aufgabe im Prompt gegeben.

- Prompt Templating: Erstellung wiederverwendbarer Strukturen oder Vorlagen für Prompts. Dies ermöglicht das dynamische Einfügen von Benutzereingaben, Daten oder Kontext in eine vordefinierte Prompt-Struktur. Hierfür braucht es tieferen Durchgriff auf das System als bei den vorher genannten Verfahren.

- Function Calling: Die Fähigkeit eines Sprachmodells zu erkennen, wann eine Anfrage eines Benutzers durch den Aufruf eines externen Tools oder einer API erfüllt werden kann, und ein strukturiertes Format (z.B. JSON) auszugeben, das die aufzurufende Funktion und ihre Argumente spezifiziert. Dies ist ein kritisches Muster für die Verbindung von Sprachmodellen mit realen Systemen und ermöglicht es ihnen, Aktionen auszuführen (z.B. einen Flug buchen, eine E-Mail senden, eine Datenbank abfragen). Architekten können Systeme entwerfen, bei denen Sprachmodelle als intelligente Orchestratoren agieren und über Funktionsaufrufe mit Backend-Diensten interagieren.

- Model Context Protocol (MCP): Ein aufkommender Standard zur Erleichterung der Kommunikation zwischen KI-Modellen/Agenten und den Tools/Datenquellen, mit denen sie interagieren müssen. Ähnlich wie APIs die Kommunikation zwischen Diensten standardisieren, zielt MCP darauf ab, einen universellen Weg für Modelle zu bieten, externe Funktionen und Daten zu verstehen und zu nutzen, was ihre Fähigkeit verbessert, in realen Arbeitsabläufen zu operieren. Architekten, die agentische Systeme oder Anwendungen entwerfen, die erfordern, dass Modelle mit Unternehmensdaten und -tools interagieren, werden MCP als wesentlich für den Aufbau interoperabler und skalierbarer Lösungen finden.

System-Design-Muster: Bausteine für intelligente Anwendungen

- RAG (Retrieval Augmented Generation): Ein Muster, bei dem die Fähigkeit eines Sprachmodells, Text zu generieren, durch das Abrufen relevanter Informationen aus einer externen Wissensbasis erweitert wird. Wenn ein Benutzer eine Frage stellt, ruft das System zunächst relevante Dokumente oder Datenausschnitte aus einer Quelle ab (z.B. einer Dokumentendatenbank, einem Wissensgraphen) und stellt diesen abgerufenen Kontext zusammen mit der Anfrage des Benutzers dem Sprachmodell zur Verfügung. Das Modell nutzt dann diese kombinierten Informationen, um eine fundierte und genauere Antwort zu generieren, was Halluzinationen reduziert und die Nutzung aktueller, domänenspezifischer Informationen ermöglicht. Architekten können RAG implementieren, um Chatbots, Frage-Antwort-Systeme und Content-Generierungstools zu bauen, die proprietäre oder ständig aktualisierte Daten nutzen.

- Agenten, A2A (Agent-to-Agent): KI-Agenten sind autonome oder halbautonome Programme, die ihre Umgebung wahrnehmen, Entscheidungen treffen und Aktionen ausführen können, um Ziele zu erreichen. Sie nutzen oft Sprachmodelle für Reasoning und Planung und verwenden Tools (über Function Calling), um mit der Welt zu interagieren. Das Agent-to-Agent (A2A) Protokoll ist ein offener Standard, der es verschiedenen KI-Agenten, die von verschiedenen Teams oder Organisationen gebaut wurden, ermöglicht, die Fähigkeiten des anderen zu entdecken und bei komplexen Aufgaben zusammenzuarbeiten. Für Architekten eröffnet das Design mit Agenten und A2A Möglichkeiten für den Aufbau anspruchsvoller, verteilter KI-Systeme, bei denen verschiedene spezialisierte Agenten zusammenarbeiten und monolithische KI-Anwendungen in überschaubarere und interoperablere Komponenten aufbrechen.

- Modalitäten, Multi-Modal: KI-Modelle sind zunehmend in der Lage, Informationen über verschiedene Modalitäten hinweg zu verarbeiten und zu generieren, wie Text, Bilder, Audio und Video. Multi-modale KI-Systeme können den Inhalt eines Bildes verstehen und eine Beschriftung generieren, Sprache hören und transkribieren, während sie die Emotion des Sprechers analysieren, oder Video aus einer Textbeschreibung generieren. Architekten, die Anwendungen entwerfen, die das Verstehen oder Generieren von reichhaltigen, multisensorischen Inhalten erfordern, werden multi-modale Modelle nutzen und die Infrastruktur berücksichtigen, die für die Handhabung verschiedener Datentypen erforderlich ist.

Governance und Sicherheit: Gewährleistung verantwortungsvoller KI

- Guard Models: Dies sind Modelle oder Mechanismen, die speziell entwickelt wurden, um die Ein- und Ausgaben anderer KI-Modelle zu überwachen. Guard Models können schädliche Inhalte filtern und sicherstellen, dass Antworten innerhalb definierter Grenzen bleiben. Architekten müssen Guard Models und andere Sicherheitsschichten in ihre KI-Architekturen integrieren, um Risiken im Zusammenhang mit der Bereitstellung potenziell unvorhersehbarer KI-Systeme zu mindern, insbesondere in sensiblen Anwendungen.

Modellauswahlstrategie: Offenheit und Flexibilität

Open Source Modelle__: Die zunehmende Verfügbarkeit von Open-Source-KI-Modellen bietet Architekten erheblich mehr Flexibilität und Kontrolle in der Lösungsentwickling als rein SaaS-basierte KI-Lösungen. Im Gegensatz zu proprietären Modellen ermöglichen Open-Source-Alternativen größere Transparenz, Anpassung (durch Fine-Tuning oder LoRA) und Bereitstellung in verschiedenen Infrastrukturumgebungen. Architekten können strategisch zwischen Open-Source- und proprietären Modellen basierend auf Kosten, Leistungsanforderungen, Anpassungsbedürfnissen und Überlegungen zur Anbieterbindung wählen.

Architektonische Überlegungen und der Weg nach vorn

Die Adoption dieses modernen KI-Tech-Stacks erfordert von Architekten, über traditionelle Softwarearchitektur hinauszudenken. Zu den wichtigsten Überlegungen gehören:

- Dateninfrastruktur: Investition in skalierbare und flexible Datenplattformen, die verschiedene Datentypen verarbeiten können, Echtzeit-Verarbeitung unterstützen und effiziente Daten-Governance und Produkterstellung ermöglichen.

- MLOps und AIOps: Einrichtung robuster Pipelines und Praktiken für die Automatisierung der Bereitstellung, Überwachung und Verwaltung von KI-Modellen und agentischen Systemen. Dies umfasst kontinuierliche Integration/kontinuierliche Bereitstellung (CI/CD) für Modelle, automatisierte Leistungsüberwachung und Infrastrukturmanagement für KI-Workloads.

- Tooling und Frameworks: Auswahl geeigneter Bibliotheken, Frameworks und Plattformen, die die diskutierten Technologien unterstützen, unter Berücksichtigung von Faktoren wie Benutzerfreundlichkeit, Community-Unterstützung, Skalierbarkeit und Integrationsfähigkeiten.

- Sicherheit und Datenschutz: Implementierung starker Authentifizierungs- und Autorisierungsmechanismen, Datenverschlüsselung, Techniken zur differentiellen Privatsphäre und Compliance-Frameworks (z.B. DSGVO, EU AI Act) zum Schutz sensibler Daten und KI-Systeme.

- Talent und Fähigkeiten: Erkennen der Notwendigkeit von Teams mit Expertise in Datenengineering, MLOps, Prompt Engineering und spezialisierten KI-Techniken.

- Kostenmanagement: Sorgfältige Bewertung der Rechen- und Speicherkosten, die mit dem Training, Fine-Tuning, der Bereitstellung und dem Betrieb von KI-Modellen verbunden sind, insbesondere großen Sprachmodellen, und Verwendung von Techniken wie Destillation und LoRA zur Optimierung der Ressourcennutzung.

Architekten haben die Möglichkeit, die vorhandenen KI-Technologien auf neuartige Weise zu kombinieren, um leistungsstarke und intelligente Lösungen zu schaffen, die zuvor unmöglich waren. Zum Beispiel ermöglicht die Kombination von RAG mit Function Calling einem Sprachmodell, Fragen basierend auf internen Dokumenten zu beantworten und dann basierend auf den abgerufenen Informationen Maßnahmen zu ergreifen. Die Implementierung von Agenten, die über A2A kommunizieren, multi-modale Fähigkeiten nutzen und durch Sicherheitsmodelle geschützt sind, kann zu hochautonomen und zuverlässigen Unternehmens-Workflows führen.

Fazit

Die Landschaft der KI entwickelt sich in atemberaubendem Tempo weiter und bietet sowohl immense Chancen als auch erhebliche Herausforderungen für Unternehmens- und Softwarearchitekten. Der Unterschied zwischen der erfolgreichen Nutzung von KI und dem Fallen in die Fallen naiver Implementierung liegt in einem Engagement für ‘well-architected’ Prinzipien und einem tiefen Verständnis des modernen KI-Tech-Stacks.